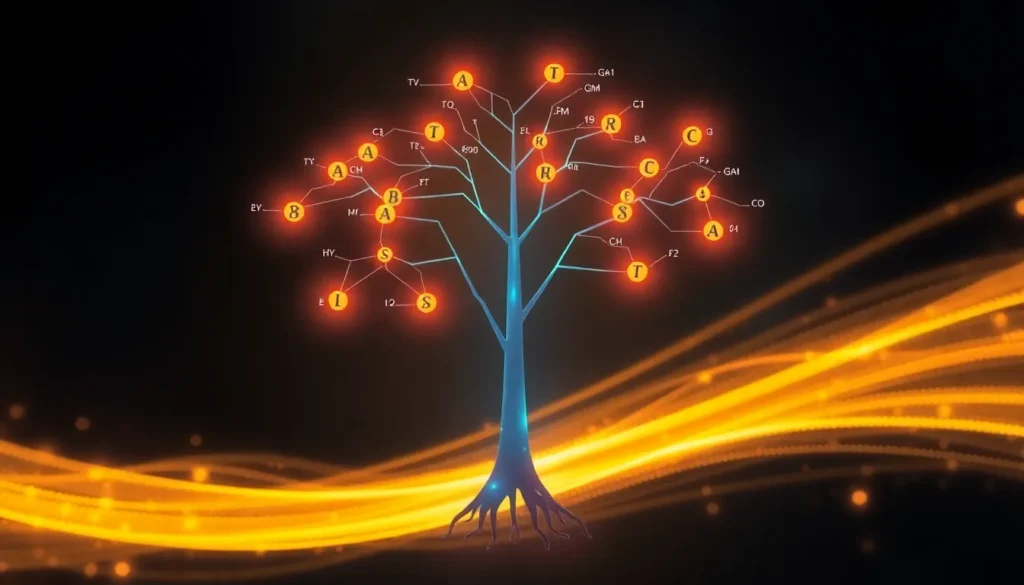

O Algoritmo Árvore de Decisão: Entendendo Conceitos e Funcionamento

O algoritmo de Árvore de Decisão (Decision Tree) é uma ferramenta fundamental no campo do Machine Learning, utilizada para modelar estratégias que permitem a realização de modelagem não linear com funções não paramétricas.

Neste artigo, exploraremos o que é este algoritmo, suas terminologias essenciais, como ele funciona com cálculos matemáticos, o método de melhor divisão baseado no Ganho de Informação, como as previsões são feitas e, por fim, suas vantagens, desvantagens e aplicações no mundo real.

O que é o Algoritmo de Árvore de Decisão?

Uma Árvore de Decisão é uma estratégia de modelagem de Machine Learning que opera sob o princípio de criar decisões baseadas em condições. A cada passo, tomamos uma decisão e, com base nela, avançamos para o próximo nível ou etapa do processo decisório, até atingirmos uma conclusão final.

Este algoritmo é classificado como não linear, pois consegue detectar padrões não lineares nos dados. Além disso, é não paramétrico, o que significa que não exige suposições prévias sobre os dados, como a necessidade de uma distribuição normal ou dados padronizados. Dados em formatos não padronizados podem ser trabalhados com este algoritmo.

O processo de aprendizado ocorre dividindo os dados com base em uma condição. Essa divisão visa particionar os dados de forma a reduzir o erro ou a incerteza presente no processo de tomada de decisão. O objetivo é reduzir essa incerteza em cada etapa de divisão subsequente até que a incerteza atinja o nível zero, indicando uma decisão pura.

Terminologias Chave em Árvores de Decisão

O processo de tomada de decisão em uma árvore é estruturado em torno de três nomenclaturas principais:

- Nó Raiz (Root Node): É o ponto de partida que representa o conjunto de dados completo que estamos analisando. A primeira divisão dos dados ocorre neste nó, baseada na primeira característica selecionada.

- Nó de Decisão (Decision Node): São os nós onde a divisão dos dados ocorre, criando subárvores com base em certas condições. Estes nós exigem uma decisão para prosseguir.

- Nós Folha (Leaf Nodes): São os nós terminais ou finais, representando os resultados ou previsões. Eles geralmente indicam a variável alvo dos dados, seja em um problema de classificação ou regressão.

Outro termo importante é a Poda (Pruning), que é o processo de controlar o crescimento da árvore para evitar o overfitting (sobreajuste). Existem duas metodologias principais de poda:

- Pré-poda (Pre-pruning): Impede que a árvore cresça excessivamente desde o estágio inicial.

- Pós-poda (Post-pruning): Permite que a árvore cresça completamente e, então, remove certos ramos para evitar o sobreajuste. Este conceito está relacionado à parada antecipada (early stopping).

Como a Árvore de Decisão é Construída: Ganho de Informação

A construção da árvore envolve encontrar a melhor característica (feature) para iniciar a divisão do conjunto de dados. Isso é feito iterativamente, calculando o Ganho de Informação (Information Gain) para cada característica disponível. A característica que fornecer o maior Ganho de Informação é escolhida para o primeiro split.

O Ganho de Informação é definido como a mudança na impureza (ou indecisividade) entre um nível e outro.

Para calcular o Ganho de Informação, precisamos medir a impureza no conjunto de dados completo e, em seguida, medir a impureza após a divisão baseada em uma determinada característica. O objetivo é selecionar a divisão que maximize essa redução de impureza.

Medindo a Impureza: Gini Impurity e Entropia

Dois métodos comuns para medir a impureza são o Gini Impurity e a Entropia (também conhecida como log loss).

Gini Impurity

O Gini Impurity é uma medida da mistura de nós ou do quão impura é a tomada de decisão nos dados. É calculado como:

$$

\text{Gini Impurity} = 1 – \sum_{i=1}^{n} (p_i)^2

$$

Onde $p_i$ é a probabilidade da classe $i$. Um valor de Gini Impurity igual a zero indica um nó puro (nenhuma incerteza), enquanto um valor máximo (por exemplo, 0.5 em uma classificação binária com distribuição 50/50) indica máxima impureza.

Entropia

A Entropia quantifica o nível de aleatoriedade ou desordem nos dados, medindo a incerteza de uma previsão incorreta. É calculada pela fórmula:

$$

\text{Entropia} = – \sum_{i=1}^{n} p_i \cdot \log_2(p_i)

$$

Uma Entropia de 1 significa um nó completamente impuro (distribuição de classes igual), e uma Entropia de 0 significa um nó puro.

O Ganho de Informação é obtido comparando a entropia (ou Gini Impurity) do nó pai com a média ponderada das entropias dos nós filhos resultantes de uma divisão. O algoritmo escolhe o split que maximiza essa diferença.

Exemplo Prático: Construção de uma Árvore

Consideremos um conjunto de dados simples para aprovação de empréstimo com as características: Renda (Alta/Baixa), Pontuação de Crédito (Alta/Baixa) e o Status (Aprovado/Rejeitado).

No nó raiz, com 4 casos (3 Aprovados e 1 Rejeitado), a impureza inicial (Gini) é $3/8$.

Se dividirmos usando a característica Renda Alta/Baixa:

1. **Renda Alta:** 2 casos, ambos Aprovados. A impureza (Gini) neste subconjunto é 0 (nó puro).

2. **Renda Baixa:** 2 casos, 1 Aprovado e 1 Rejeitado. A impureza (Gini) neste subconjunto é 0.5 (máxima incerteza).

Calculando a impureza média ponderada após a divisão por Renda, comparamos este valor com o $3/8$ inicial. Se a divisão por Renda resultar em um maior Ganho de Informação (maior redução de impureza) do que a divisão por Pontuação de Crédito, Renda será o nó raiz.

O processo se repete recursivamente: cada subconjunto de dados resultante de um split é tratado como um novo conjunto completo, e o melhor atributo é selecionado para dividir aquele novo nó, até que se atinja a pureza (Impurity = 0) ou critérios de parada sejam satisfeitos.

Processo de Previsão

Uma vez que a Árvore de Decisão está construída, a previsão para novas entradas é simples:

1. O novo conjunto de entradas segue o caminho definido pelas condições em cada nó da árvore.

2. Ele percorre o caminho (branch) até atingir um nó folha.

3. O valor associado a esse nó folha é a previsão final.

Vantagens e Desvantagens

As Árvores de Decisão possuem características notáveis:

Vantagens

- Fácil Interpretação: São fáceis de entender e visualizar, pois refletem princípios básicos de tomada de decisão humana.

- Versatilidade: Podem ser usadas tanto para problemas de regressão quanto de classificação.

- Tratamento de Dados: Conseguem lidar com dados tanto categóricos quanto numéricos, exigindo pouca ou nenhuma pré-processamento (devido à sua natureza não paramétrica).

Desvantagens

- Sobreajuste (Overfitting): São muito propensas ao overfitting. Se permitidas crescer totalmente, tentarão alcançar a resposta correta para cada ponto de treino, capturando ruídos.

- Instabilidade: Uma pequena alteração nos dados de entrada pode levar a uma mudança significativa na estrutura da árvore.

- Viés (Bias): Se houver desequilíbrio de classes (class imbalance), o algoritmo pode apresentar vieses.

Para mitigar o overfitting, técnicas como a poda ou o uso de algoritmos de ensemble baseados em árvores, como Random Forest ou Gradient Boosting (incluindo XGBoost e AdaBoost), são comumente empregadas.

Aplicações no Mundo Real

O conceito de Árvore de Decisão é amplamente utilizado em diversos setores:

- Análise de Crédito: Previsões de aprovação de empréstimos.

- Diagnóstico Médico: Classificação de doenças, como diagnóstico de câncer de mama, baseado em relatórios médicos.

- Segmentação de Clientes: Utilizado em marketing para categorizar clientes.

- Análise de Produto: Detecção de produtos e análise de marketing.

Em qualquer problema de classificação onde os dados apresentam uma relação não linear, a Árvore de Decisão é um algoritmo confiável e frequentemente utilizado como base para modelos mais avançados.

Perguntas Frequentes

- O que é um nó folha em uma Árvore de Decisão?

É o nó terminal da árvore, representando o resultado final ou a previsão, e não pode ser dividido posteriormente. - Como se mede o Ganho de Informação?

O Ganho de Informação é calculado pela diferença entre a impureza (Entropia ou Gini Impurity) do nó pai e a média ponderada das impurezas dos nós filhos após a divisão por uma característica específica. - Por que as Árvores de Decisão são propensas a overfitting?

Elas tendem a crescer excessivamente, aprendendo o ruído específico dos dados de treinamento em vez de generalizar os padrões subjacentes. - Qual a diferença entre pré-poda e pós-poda?

A pré-poda restringe o crescimento da árvore durante a construção, enquanto a pós-poda permite o crescimento completo e depois remove os ramos para simplificar e reduzir o overfitting. - É possível usar Árvores de Decisão para regressão?

Sim, o algoritmo pode ser aplicado tanto para classificação quanto para problemas de regressão.